前段时间,发哥SEO在帮助一个商城做优化时,发现一个问题。明明我已经对页面进行了一些优化,但是收录抓取时,总是会出现抓取不正常,或者不收录。

经过一系列的分析,最终确认以下几点原因:

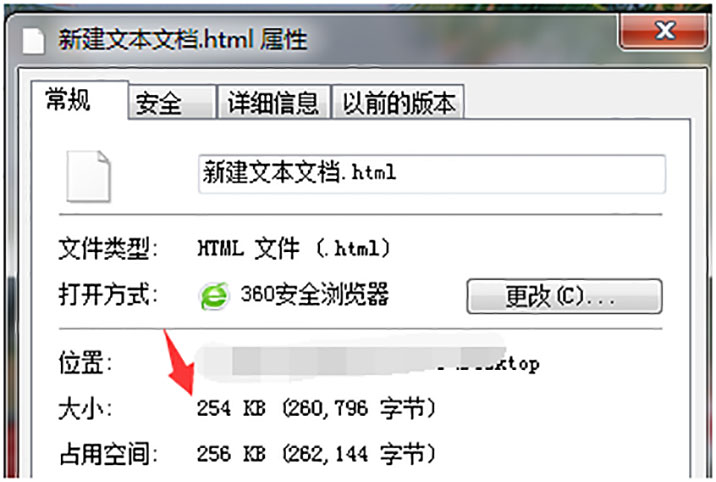

1、网站针对爬虫爬取做的优化,直接将图片二进制内容放到了html中导致页面长度过长,网站页面长度达254kb;

2、 站点优化后将主体内容放于最后,图片却放于前面;

3、爬虫抓取内容后,页面内容过长被截断,已抓取部分无法识别到主体内容,最终导致页面被认定为空短而不收录。

所谓的页面过长,又叫页面大小。在分页方式中,用户程序的地址空间被划分成若干个固定大小的区域,称为“页”(或“页面”)。简单点说就是一个页面重量。

如何查看一个页面的重量

方法1、打开网页,对着网页右击——选择查看原代码——复制所有原代码。回到桌面,新建一个txt文档,将复制的原代码保存至txt文档,将txt文档后缀改为html,然后对着修改后的文件右击,属性。这时就能清楚得看到这个文档大小。这就是所谓的页面大小。

方法2、进入FTP,找到原文件,右击查看属性。然后就会发现显示这个文件的大小。

SEO优化建议方案

1、不建议站点使用js生成主体内容,如js渲染出错,很可能导致页面内容读取错误,页面无法抓取;

2、 如站点针对爬虫爬取做优化,建议页面长度在128k之内,不要过长;

3、针对爬虫爬取做优化,请将主题内容放于前方,避免抓取截断造成的内容抓取不全。

在做SEO优化路途上,真的要不断不断的去研究去发现。看似很简单的问题,如果不经过深层的分析,你根本无法发现问题所在,谈何解决问题。就拿页面大小这个来说,如果不懂得程序方面的知识,如何发现这些?那又该如何解决问题。不过没关系,在SEO工作中,如果遇到不懂的可以直接给发哥来电。

相关文章

相关文章

精彩导读

精彩导读

热门资讯

热门资讯 发哥推荐

发哥推荐